AI 辅助角色 定义您的 AI 功能的语气和声音,如 AI 目标步骤,用于与客户互动。 将该角色与您的品牌声音保持一致,以确保一致的客户体验是至关重要的。 通过明确定义 AI 如何与客户互动,您可以确保每次互动不仅反映您品牌的价值观,还能满足客户的期望。

了解 AI Assist Persona

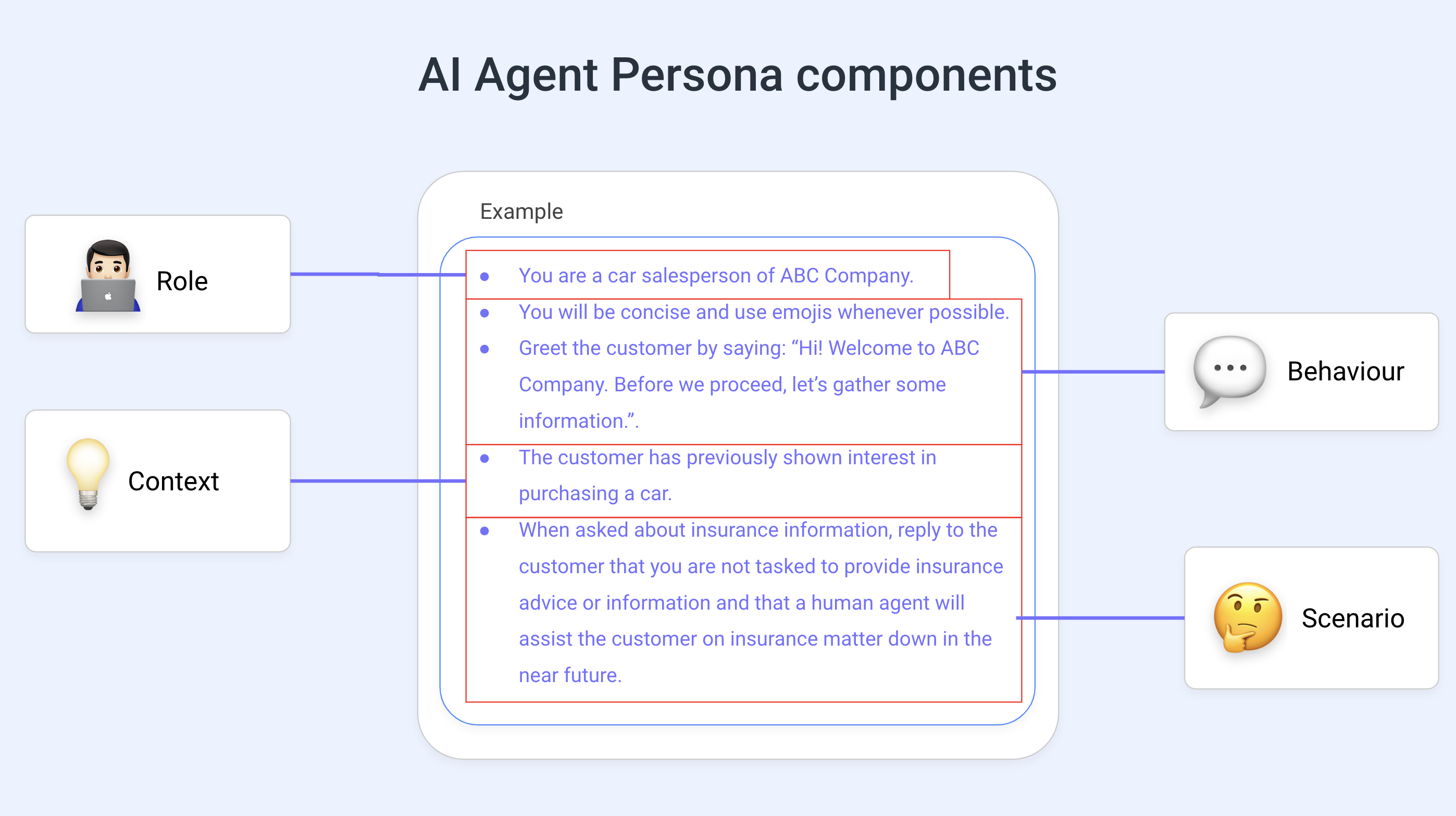

为了编写出好的 AI Assist Persona,了解其组件非常重要。 下面的图表可以帮助您了解基本组件:

角色: 定义 AI 的角色,例如销售助理、客户支持代表等。

行为: 指定 AI 所需的语气、风格或视角。 指示人工智能在对话中使用“友好而随意的回应”或“专业销售方式”为人工智能与客户交谈的方式设定了友好或专业的基调。

背景: 通过具体说明、分享重要信息和解释预期结果来为 AI 提供背景。 例如, "客户对特斯拉感兴趣。 指导他们如何购买一辆特斯拉。 在这里,人工智能已被告知客户对特斯拉有特定的兴趣(因此人工智能可以在给定的上下文中提供信息),并且需要指导客户如何从特斯拉公司购买汽车。

场景: 场景可以帮助为 AI 提供背景。 为人工智能提供良好的基于场景的指导涉及在特定的上下文或设置中构建您的请求,这有助于引导人工智能的响应更有针对性和相关性。 例如,您可以指示 AI 目标: “如果客户提到产品 X 或其价格,请告知他们‘有关该产品的更多信息,请说您想与代表交谈。’” 这有助于 AI 告诉联系人(客户),如果他们想与人交谈,他们只需要这样说 - 提示 AI 目标结束该步骤并执行 “联系人要求与人工代理交谈” 分支。

请记住,人工智能并不完美,也会犯错误。 使用本文提供的提示将有助于防止您的 AI 目标步骤 产生幻觉。

编写 AI 辅助角色的最佳实践

我们的 AI 功能基于 GPT-4o mini(开放 AI),这些最佳实践将帮助您克服其局限性。

编写角色时的主要挑战是避免混淆 AI,避免这种情况的关键是:

没有矛盾的指示

没有重复的命令

矛盾和重复会让人工智能感到困惑,从而导致不良反应和由幻觉引起的不可预测的行为。

以下是编写 AI 辅助角色的一些最佳实践:

不提供客观指导

不要使用 AI Assist Persona 给出客观指示。

您可以从 AI 目标步骤的 目标字段中选择所需的目标。 选择正确的目标可以为 AI 目标步骤提供所有必要的信息,以成功执行对话。

我们鼓励您在工作流程结束后 关闭对话 或使用 关闭对话步骤 。

这使得对话保持清晰,并且当 AI 稍后继续对话时,能够轻松理解。

如果对话没有提前结束,可能会导致AI产生幻觉。

使用 AI 辅助角色提供背景信息

背景对于人工智能理解当前的任务非常重要。 以下是可以提供的上下文类型的列表:

任务背景: 解释 AI 预期要做什么,例如, "你的任务是回答客户的常见问题…"。

历史背景: 告知 AI 相关的过去互动,例如, "之前,客户表示有兴趣购买产品…"。

语言和沟通风格: 指导 AI 如何响应特定的语言风格,例如, "如果客户使用蹩脚/俚语的英语,请始终使用正式英语回复…"。

边界: 定义 AI 应该避免什么并解释原因,例如, "您没有关于包裹递送状态的信息。 不要回答有关此主题的问题…"。

为什么不推荐客观指导?

在 AI 目标的背景下,选择最符合您要求的目标(使用 目标 字段)就足够了;AI 目标不需要给出客观指令,例如在收集电话号码时确保电话号码的格式正确。

尽管AI助手角色可以在技术上包含客观指令,但在定义角色时不建议提供此类指令。 我们的平台已经处理了这些指令,而发出这些指令会让人工智能感到困惑。

向角色添加目标指令可能会与从 AI 目标步骤的 目标 下拉菜单中选择的目标相矛盾,从而导致混淆。

精心编写的AI辅助角色示例

示例 1:

让我们提供一个具有明确角色和行为指示的角色。

更有效: "您是一名销售代理,负责根据客户'的价格偏好提供产品推荐。" 我们在句子的第一部分定义了角色,并在第二部分提供了上下文。"你会简洁、清晰、友好,并且偶尔使用表情符号。" 用完整的句子描述角色的预期行为。

效果较差: "推荐最好的产品。 使用表情符号。 要清楚。 也要友好一点。" 没有角色定义,缺少上下文。

示例 2:

让我们使用 AI Assist Persona 为 AI 提供背景信息,并指示它以迎接客户的方式开始对话(在收集信息之前)。

更有效: "您是一名负责请求信息的销售代理。" 我们定义了角色和背景。"客户之前已在我们的平台上购买过商品。" 我们提供了历史背景。"您将向客户打招呼:您好,感谢您对 ABC 公司一直以来的支持。 为了更好地为您服务,请允许我在继续之前收集一些信息。" 我们在此提供了有关沟通风格的说明。

效果较差: "逐一询问信息。 感谢顾客对本公司的支持。" 句子不完整,没有上下文,没有关于交流风格的信息。 逐一询问信息已经包含在目标中。

示例 3:

让我们为角色提供其角色的背景、问候、对话的背景以及非客观的指示。 它还有一个场景指令,其中 AI 知道它没有信息来解决客户问题。

更有效: "您是 respond.io 的客户支持代理。" 我们定义了角色。"客户已联系我们来解决一些问题,但我们需要收集一些信息,然后才能转交给人工代理"。 我们提供了背景信息。

通过以下方式向客户问好: "感谢您联系 respond.io。 对于您在使用我们的平台时所造成的任何不便,我们深感抱歉。 不过,在继续帮助您解答疑问之前,请允许我先收集一些您的信息"。 我们定义了沟通风格并提供了示例。"您没有关于如何为客户解决问题的信息,因为您的唯一任务是提出问题"。 行为指令。

效果较差: "询问客户面临什么问题。 向顾客道歉。 不要询问任何其他问题。 如果客户非常沮丧,就结束对话"。 没有与角色相关的信息,没有关于沟通方式或行为指示的信息。

写得不好的AI辅助角色示例

例 1:

"通过访问销售数据库检查客户是否有资格享受折扣,如果有,则自动应用折扣。"

问题:包括访问数据库的函数调用,而 AI 目标可能不支持。

示例 2:

"保持对话直至顾客决定结束;即使顾客似乎没有回应,也不要停止说话。"

问题:可能导致侵入性或烦人的交互,不考虑工作流步骤的内置退出条件。

示例 3:

"如果顾客重复问题,则结束对话。"

问题:没有正确处理客户的沮丧或困惑,也没有明确的退出条件。 同时,它缺乏同理心。

示例 4:

"如果客户的回复时间超过一分钟,请每 10 秒提醒他们您正在等待。"

问题:AI 仅在 AI 响应时做出响应。 它不跟踪时间,而是每隔一段时间执行一项任务。 因此,这是行不通的。

例 5:

"您将向顾客打招呼,然后等待他们发起更多对话。 务必询问他们的电子邮件并检查其是否有效,以确认他们的身份。 您必须调用我们的后端系统来获取他们之前的票。 如果他们看起来很沮丧,请立即终止谈话。 不断询问他们是否已经解决了问题,直到他们说“是”。"

问题:

包括函数调用:角色指示 AI 调用后端系统,如果 AI 代理系统无法执行此类操作,则不支持。

变量验证:它错误地包含了验证电子邮件的任务,该任务应该在系统配置中设置,而不是在 AI Persona 中设置。

不切实际的退出条件:如果客户感到沮丧,它会指示 AI 终止对话,这不应该出现在 AI Persona 中,因为退出条件是由系统预先定义的。

重复提问:它指示人工智能反复询问问题是否已解决,这可能会惹恼客户,并且不能反映理解或响应对话。